فایل robots.txt چیست و چه کاربردی دارد؟ این رایج ترین سوال در زمینه سئو تکنیکال است. بسیاری از تازه واردان دنیای سئو، تصور میکنند که درج دستورالعملهای فایل robots.txt دشوار است و تنها از عهده متخصصین با تجربه این حوزه بر میآید.

در حالی که با یکبار مطالعهی دقیق این مقاله، به راحتی میتوانید دستورات مورد نیاز سئو سایت را در فایل درج کنید. شاید جالب باشد که بدانید، از طریق دستوراتی که در این فایل درج میکنید، با رباتهای گوگل به طور مستقیم در ارتباط خواهید بود.

فایل robots.txt چیست؟

فایل Robots.txt یک فایل متنی است که دستورالعملها در آن درج میشود. هر کدام از دستورالعملهای درج شده در این فایل، کاربردهای متفاوتی با یکدیگر دارند. این فایل برای گوگل اهمیت زیادی دارد؛ چرا که پیش از شروع خزش سایت، ابتدا دستورات این فایل توسط رباتها خوانده میشوند.

لازم به اشاره است که تمام کارشناسان، اعم از کارشناسان On-Page و Off-Page باید نحوه ساخت فایل ربات و درج دستورالعملها را به خوبی بدانند. نکته قابل توجه این است که، المانهای بسیاری مانند سئو محتوا ، سئوی تصاویر و … وجود دارد که روی عملکرد سایت تاثیرگذار است، ساخت فایل robots.txt یکی از این المانها به شمار میآید. بنابراین، پیش از شروع فرآیند سئو سایت حتما این فایل را بسازید و به سرچ کنسول متصل کنید.

دانش اینکه فایل Robots.txt برای چیست و در کدام قسمت CMS شما تعریف میشود؟ یا اینکه، نحوه اتصال آن به سرچ کنسول چگونه است؟ و چطور میتوان در فایل دستور نویسی کرد؟ برای تمام کسانی که در این حوزه فعالیت میکنند، مهم و ضروری است. تفاوت میان کسانی که عملکرد حرفهای در سئو دارند با افراد مبتدی، در رعایت همین نکات کوچک اما مهم مشخص میشود.

گوگل در خصوص تنظیمات فایل Robots مقاله های جذابی دارد که در بخش مقالات گوگل به آنها اشاره شده است.

A robots.txt file tells search engine crawlers which URLs the crawler can access on your site. This is used mainly to avoid overloading your site with requests; it is not a mechanism for keeping a web page out of Google. To keep a web page out of Google, block indexing with

noindexor password-protect the page.

هدف از فایل robots.txt چیست؟

این فایل از با هدف زیر به وبسایت اضافه میشود:

- جلوگیری از خزش در صفحات خاص (درباره ما – تماس با ما – صفحه بندی و …) توسط روبات موتورهای جستجو

- جلوگیری از خزش در کل سایت

- کمک به پیدا کردن نقشه سایت (Sitemap)

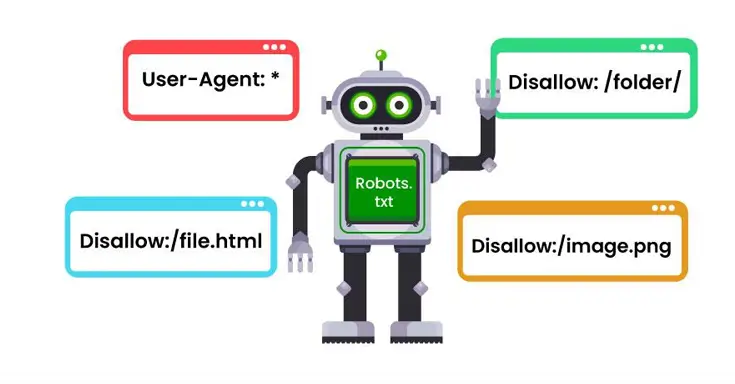

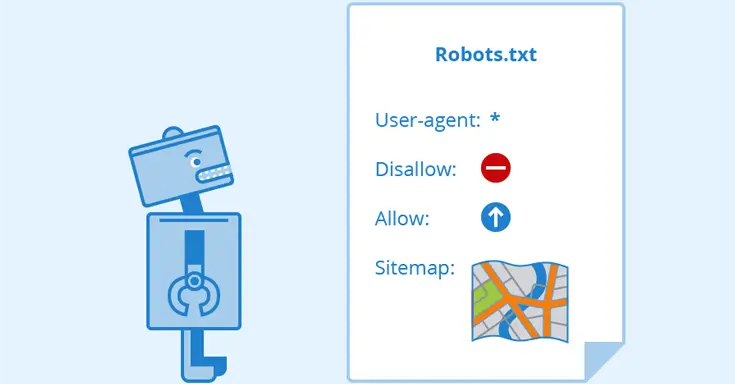

اصطلاحات مربوط به فایل Robots.txt چیست؟

- User-agent: برای معرفی موتور جستجوی مورد نظر.

- Disallow: صفحاتی که موتور جستجو اجازه خزش آن را ندارد.

- Allow: صفحاتی که موتور جستجو اجازه خزش آن را دارد.

- Crawl-delay: نرخ خزیدن در گوگل را مشخص میکند.

- Sitemap: برای معرفی نقشه سایت به ربات که البته انجام این کار با سرچ کنسول هم امکان پذیر است.

- No-index: برخی از صفحات مانند صفحات تکراری اجازه ایندکس شدن را نمیدهید.

- No-follow: برخی لینکهایی که از اعتبار سایت برخوردار نیستند را مشخص می کنید.

-

تمپلیت سئو برای پروژه230,000 تومان – 1,250,000 تومان

-

KPI پلن سئو برای ۱۲ ماه350,000 تومان – 2,500,000 تومان

-

بریف محتوای متنی280,000 تومان – 1,250,000 تومان

-

تقویم مناسبتهای ۱۴۰۳250,000 تومان – 1,500,000 تومان

معرفی انواع ربات گوگل

رباتهای گوگل به چند دسته تقسیم میشوند. هر کدام، مسئولیتهایی را بر عهده دارند. با توجه به اینکه چقدر وب سایت فعالی دارید، Crawl Budget متفاوت خواهد بود. رباتها، میان وب سایتهایی که در طول روز فعالیتهای مدوام دارند، نسبت به وب سایتهایی که فعالیت چندانی ندارند، تمایز قائل میشوند. در قسمت Crawl State سرچ کنسول میتوانید دفعات بررسی صفحههای سایت را مشاهده کنید.

مهمترین ربات گوگل که باید بشناسید:

- AdSense: این ربات صفحات تبلیغاتی را مشاهده میکند.

- Google Bot Image: این ربات تصاویر را بررسی میکند.

- Google Bot News: این ربات سایتهای خبری را ایندکس میکند

- Google Bot Video: این ربات ویدئوها را بررسی میکند.

- Google Bot: این ربات صفحات وب را ایندکس و کشف میکند.

فایل Robots.txt کجاست؟

چطور فایل Robots.txt را پیدا کنیم؟ احتمالا این پرسش به ذهن شما هم رسیده است. وارد صفحه اصلی سایت شوید، در انتهای آدرس URL سایت، عبارت /robots.txt را اضافه و دکمه Enter فشار دهید. حالا یک فایل متنی مقابل شما باز شده است. یکی از راهها برای اینکه متوجه عملکرد بخشی از رفتار تکنیکال رقیب شوید، مشاهده فایل متنی Robots.txt سایت رقیب است.

در صورتی که نیاز به ویرایش فایل دارید، باید وارد اکانت هاستینگ شوید. فایل ربات در root قرار دارد و برای اعمال تغییرات، باید آن را باز کنید. اگر سایت تازه نفس دارید و این فایل را در Root پیدا نمیکنید، کافی است یک فایل متنی دقیقا با همین نام، بسازید و در اکانت هاستینگ خود آپلود کنید. هنگام ساخت اکانت، به اسم ربات و همچنین، بزرگ و کوچکی حروف توجه کنید.

چگونه فایل Robots.txt بسازیم؟

ساختار فایل robots.txt متنی است؛ بنابراین، برای ساخت به یک Notepad ساده نیازمندید. شما در انتخاب ویرایشگر برای ساخت فایل هیچ محدودیتی ندارید. با هر ویرایشگری که خروجی TXT به شما بدهد، امکان ساخت، فایل ربات گوگل را دارید. اگر به این مقاله علاقهمند شدید احتمالا به مقاله ریجکس و نحوه نوشتن آن نیز علاقهمند شوید.

مراحل ساخت فایل Robots.txt:

- یک فایل Notepad یا ویرایشگر متنی که خروجی TXT میدهد را باز کنید.

- فرمت فایل را هنگام ذخیره به UTF-8 تغییر بدهید.

- فایل را باز کنید و دستورات دلخواه را درج کنید.

- برای درج دستورات مورد نیاز به انتهای همین صفحه بروید و از راهنماییها استفاده کنید.

- حالا فایل برای آپلود در ریشه یا root هاستینگ آماده است.

چگونه فایل robots.txt را در Root بارگذاری کنیم؟

وارد اکانت هاستینگ شوید. همانطور که گفته شد، فایل ربات باید در قسمت ریشه یا root قرار بگیرد. منظور از اینکه در Root قرار بگیرد، این است که، در پوشه اصلی میزبان هاست سایت باشد.

https://hparviz.ir/robots.txt

تست فایل robots.txt

اگر وبسایت یا وب سایت به سرچ کنسول متصل باشد، شما میتوانید از طریق ابزارهای آن، فایل رباتهای گوگل را راستی آزمایی کنید. اگر فایل را به درستی آپلود کرده باشید میتوانید در ابزار سرچ کنسول مشاهده کنید.

- وارد سرچ کنسول سایت شوید.

- سرچ کنسول را در حالت domain property قرار دهید.

- فهرست فایلهای robots.txt میتوانید مشاهده کنید.

- اگر فایل روبات به درستی آپلود نشده باشد، در این بخش خطا مشاهده میکنید.

- با کلیک بر روی آیکون سه نقطه در سمت راست میتوانید به گوگل درخواست بدهید که مجددا فایل ربات را بررسی کند.

فایل Robots.txt چگونه کار می کند؟

اگر نمیخواهید، برخی از صفحات سایت شما توسط ربات بررسی شود، پس وقت آن رسیده که دستور نویسی در فایل ربات را شروع کنید. در فایل robots.txt ، منظور از ربات چیست؟ ربات گوگل یا موتور جستجوی خاصی را مدنظر دارید؟ یا اینکه تصمیم دارید دستورالعملها را به همه موتورهای جستجو اعلام کنید؟ رباتها، همیشه از ابتدای فایل را میخوانند و براساس دستورات درج شده، عمل میکنند. به عنوان مثال، در صورتی که اجازه خواندن صفحات No-Index را ندهید، هیچ کدام از صفحاتی که هنوز توسط موتور جستجو Index نشدند، بررسی نخواهند شد.

بهینه سازی فایل Robots.txt

با توجه به توضیحات ارائه شده در بالا، تمام سایت ارزیابی میشود. در سئو تکنیکال، بسیاری از مشکلات که سرچ کنسول گزارش میدهد، این فایل، قابل حل است. سرچ کنسول و گزارشهای آن برای بهبود عملکرد سایت، یک راهنما به شمار میآید. به همین دلیل، هنگام مواجه با مشکلات باید بتوانید، درست تشخیص بدهید و برای آنها برنامه ریزی کنید. شناخت برخی نکات ریز تاثیر زیادی روی عملکرد سایت دارد. اگر میخواهید یک متخصص سئو باشید، لازم است درباره تمام نکات ریز و درشت داخل سایت، اطلاعات کافی را دریافت کنید.

رفع ارور تکنیکال سئو با دستورات Robots.txt

دستورات زیر به شما کمک میکند تا بسیاری از مشکلات تکنیکال سئو را رفع کنید. یادگیری آنها ساده است، در زیر تمام دستورات را با توضیح ارائه دادیم.

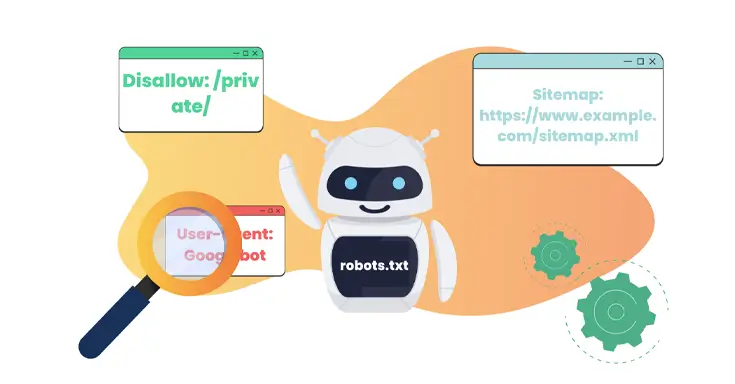

دستور user-agent فایل Robots.txt

این دستور را به شکل زیر مینویسیم:

User-agent:*

این دستور مشخص میکند که دستورات بعدی برای تمام موتورهای جستجو نوشته شده است.

User-agent: Googlebot

این دستور مشخص میکند که دستورات بعدی برای ربات گوگل نوشته شده است.

دستور disallow فایل Robots.txt

همانطور که از اسم آن پیداست، مشخص میکند چه صفحاتی را نباید بررسی کند. در واقع فولدرهای غیر مجاز برای گوگل بات به این روش مشخص میشود.

User-agent:*

Disallow: /photos

این دستورات نشان میدهد که بررسی تصاویر توسط تمام رباتهای تمام موتورهای جستجو غیر مجاز است. به بیان دیگر، فولدر تصاویر توسط هیچ موتورجستجو اجازه بررسی یا ایندکس را ندارد.

به دو دستور زیر توجه کنید:

User-agent:*

Disallow:

این دستور اجازه دسترسی یا بررسی تمام فایلها را میدهد.

User-agent:*

Disallow:/

این دستور، تمام صفحات یا به عبارتی، تمام فایلها را برای ربات، مسدود میکند.

دستور allow فایل Robots.txt

User-agent:*

Disallow: /photos

Allow: /photos/x.jpg

این دستور بیان می کند که هیچ رباتی در هیچ موتور جستجویی اجازه دسترسی به فولد تصاویر را ندارد به جزء فایل x.jpg

دستور Crawl-delay فایل Robots.txt

این دستور به عنوان نرخ تاخیر روی درخواستها رباتها شناخته میشود. معمولا برای ایجاد نرخ تاخیر روی ربات گوگل از سرچ کنسول استفاده میشود. برای استفاده از این دستور باید شناخت کافی درباره سئو تکنیکال داشته باشید، زیر عدم شناخته و استفاده از دستورات ربات، گاهی باعث آسیب به سئو سایت میشود.

دستور site map فایل Robots.txt

Sitemap: https://hparviz.ir/sitemap.xml

این دستور مسیر سایت مپ را نشان میدهد.

جمع بندی فایل robots.txt چیست؟

در این مقاله به نکات مهم و ضروری و البته پر کاربرد اشاره کردیم. از این طریق سعی کردیم به بررسی و حل چند مثال بپردازیم تا موضوع برای شما شفاف سازی شود. هر چقدر ربات گوگل را از روند فعالیت سایت با خبر کنید، ارزیابی را برای آن ساده کرده و این امر روی رتبه بندی سایت شما تاثیر می گذارد. لازم است بدانید که اگر میخواهید یک متخصص سئو شوید باید درباره فایل ربات اطلاعات جامع و کاملی داشته و بتوانید از این اطلاعات به بهترین شکل استفاده کنید.

سوالات متداول

چرا فایل Robots.txt در سئو مهم است؟

مهم نیست، وبسایت شما بزرگ است یا کوچک، در هر حال فایل ربات همانطور که از اسم آن پیداست به شما امکان کنترل ربات موتورهای جستجو مخصوصا گوگل را میدهد.

چرا به فایل robots.txt نیاز دارید؟

برای بهینه سازی سایت، در هر زمینهای اعم از خارجی و داخلی و البته تکنیکال سایت لازم است.

عواقب عدم تعریف فایل Robots.txt چیست؟

ربات گوگل یا هر موتور جستجویی به تمام صفحات شما دسترسی دارد و همه صفحات را ایندکس میکند. برخی صفحات که ایندکس شدن آنها باعث کاهش رتبه سایت میشود باید از دید گوگل حذف شده و در صورت نداشتن فایل Robots.txt با مشکل مواجه خواهید شد.

14 دیدگاه

1402/11/28 زمان 5:43 ب.ظ

چه مقاله جذابی بود ممنون، چجوری سرچ سایت رو ببندم ممنون میشم راهنمایی بفرمایید؟

1402/12/06 زمان 10:15 ب.ظ

سلام میلاد عزیز وقت شما بخیر، در کل بستگی به ساختار سرچ سایت و CMS شما داره من چند نمونه رو خدمت شما عرض میکنم.

Disallow: /search/

Disallow: /?

Disallow: *?s=

Disallow: *&s=

با این چنین دستوراتی از داخل فایل Robots.txt میشه سرچ رو بست

1402/12/06 زمان 9:32 ب.ظ

سلام روز شما بخیر،من میخوام تو Robots.txt بخش Feed و RSS رو ببندم ممنون میشم راهنمایی بفرمایید

1402/12/06 زمان 10:20 ب.ظ

سسلام پارسا جان برای این کار کافیه در بخش Ribots.txt سایت خودتون این بخش رو اضافه کنید:

Disallow: /feed/

Disallow: */feed

Disallow: */rss

1403/01/13 زمان 11:29 ب.ظ

سلام.آیا استفاده از دستور زیر داخل فایل رباتس درست هست؟

*/Allow: /wp-content

1403/01/14 زمان 3:25 ق.ظ

سلام نانور عزیز وقت شما بخیر

من این دسترسی رو بهینه و منطقی نمیبینم، چرا باید تمام پوشه های داخلی wp-content کرال شود؟ پوشه های مربوط به قالب و افزونه ها به عنوان مثال؟

ترتیب دستورات در فایل robots.txt بسیار مهم است و تغییر ترتیب دستورات میتواند تفاوتهای قابل توجهی در دسترسی رباتها به بخشهای وبسایت ایجاد کند. در نتیجه، بهتر است به این شکل اضافه شود:

User-agent: *

Disallow: /wp-content/

Allow: /wp-content/uploads/

Allow: /wp-admin/admin-ajax.php

در این حالت، ابتدا از دستور “Disallow” برای ممنوع کردن دسترسی به پوشه `wp-content` استفاده میشود. سپس با دستور “Allow” به رباتها اجازه دسترسی به پوشه `uploads` درون `wp-content` و فایل `admin-ajax.php` در `wp-admin` را میدهیم.

با استفاده از این ترتیب، رباتها به پوشههای دیگری که در `wp-content` قرار دارند، مانند پوشههای پلاگینها و قالبها، دسترسی ندارند ولی به پوشه `uploads` و فایل `admin-ajax.php` مجاز هستند. پوشه `uploads` مربوط به تصاویر سایت و مدیا ها میباشد.

1403/03/16 زمان 2:07 ب.ظ

سلام وقتتون بخیر

برای استفاده از دستور Crawl-delay حتما باید به سئو تکنیکال مسلط بود

1403/03/28 زمان 1:19 ب.ظ

سلام مژگان عزیز وقت شما بخیر، در پاسخبه سوال شما باید عرض کنم:

Crawl-delay در سئو به یک دستور در فایل robots.txt مربوط میشود که به موتورهای جستجو میگوید چقدر باید بین دو درخواست صفحه توسط ربات آنها صبر کنند.

به عبارت دیگر، Crawl-delay مشخص میکند که ربات موتور جستجو باید چه مدت (برحسب ثانیه) بین دو درخواست صفحه صبر کند. این به موتورهای جستجو کمک میکند تا فشار زیادی بر روی سرور سایت وارد نکنند و همچنین احتمال بروز خطا یا دسترسی غیرمجاز به سایت را کاهش میدهد.

مقدار Crawl-delay معمولا بین 1 تا 10 ثانیه است، اما میتواند بیشتر هم باشد بسته به حجم ترافیک و توان سرور سایت. این دستور برای سایتهای پر ترافیک بسیار مفید است.

در مجموع، Crawl-delay به موتورهای جستجو کمک میکند تا بدون ایجاد فشار زیاد بر روی سرور سایت، به بررسی و ایندکس کردن محتوای آن بپردازند. این امر به سئو و بهبود رتبه سایت در نتایج جستجو کمک میکند.

1403/03/16 زمان 3:43 ب.ظ

سلام وقت بخیر برای صفحات pagination چه دستوری رو تو فایل ربات بنویسم که صفحات بعدی رو نزنه؟

1403/03/28 زمان 1:15 ب.ظ

سلام مژگان عزیز وقت شما بخیر، شما میتونید با دستور: Disallow: /*?page در فایل ربات خودتون pagination رو ببندید، اگر از افزونه رنک مث هم استفاده بفرمایید این ویژگی در افزونه دیده شده و نیاز به بستن از فایل ربات نیست، گرچه کار از محکم کاری عیب نمیکنه :))

1403/03/28 زمان 2:01 ق.ظ

سلام وقت بخیر

بنده با یک افزونه لینک های داخلی و خارجی سایتم را بررسی کردم و تعداد زیادی از این نمونه لینک ها موجود بود. اینا مشکل حساب میشه؟ راه حلش را اگه لطف کنید بگید ممنون میشم.

داخلی:

فوتر سایتفوتر

https://vbvector.ir/wp-admin/post.php?post=266&action=elementor

dofollow

mega-item-602نوشته

https://vbvector.ir/wp-admin/post.php?post=1037&action=elementor

dofollow

mega-item-20نوشته

https://vbvector.ir/wp-admin/post.php?post=1073&action=elementor

dofollow

المنتور Popup #19151پاپ آپ

https://vbvector.ir/wp-admin/post.php?post=19151&action=elementor

dofollow

خارجی:

یادگیری وردپرس

https://learn.wordpress.org/

dofollow

پشتیبانی

https://fa.wordpress.org/support/forums/

dofollow

بازخورد

https://wordpress.org/support/forum/requests-and-feedback

1403/03/28 زمان 12:30 ب.ظ

سلام حبیب عزیز وقت شما بخیر، در پاسخ به سوال شما باید عرض کنم لینک هایی مثل: https://vbvector.ir/wp-admin/post.php?post=266&action=elementor داره از بکند سایت خونده میشه و احتمالا به سایت لاگین هستید، اگر چنین هست لطفا به عنوان یک کاربر معمولی چک بفرمایید. اگه باز همچین موردی بود بفرمایید بررسی بیشتر انجام بشه.

1403/03/29 زمان 4:40 ب.ظ

متشکرم که پاسخ دادید. کاملا درست فرمودید.

سپاس

1403/03/30 زمان 4:35 ب.ظ

خواهش میکنم حبیب عزیز موفق باشید.